-

自然言語処理学研究室

Li Huayang

Li Huayang

解釈可能な自然言語処理

解釈可能性 ニューロシンボリック ニューラルテキスト生成 -

ニューラルネットワークの意思決定プロセスを理解し、信頼性向上を目指す

私は学部時代に機械学習について学んでいた時、特に言語関連の人工知能に魅力を感じていました。しかし、現在のニューラルネットワークは「解釈可能性の欠如」という大きな欠点を抱えています。特にテキスト生成では、ハラシネーションやジェンダーバイアスなどの望ましくない結果が頻繁に生じているにも関わらず、その原因はほとんど解明されていません。日常生活で広く使用されている音声アシスタントがニューラルネットワークモデルに完全に依存していないのは、このためです。

ニューラルネットワークモデルの内部動作を理解し、意思決定プロセスを知ることができれば、これらの要因を特定し、軽減することが可能になる。そう考えて、研究を始めました。

言語関連に興味を抱いたのは、映画『アイアンマン』で主人公をサポートするジャービスのように、人間の言葉を理解して会話できるプログラムが実現可能だと感じたため

言語関連に興味を抱いたのは、映画『アイアンマン』で主人公をサポートするジャービスのように、人間の言葉を理解して会話できるプログラムが実現可能だと感じたためブラックボックスの性質を解明する「ニューロシンボリックアプローチ

本研究ではニューラルネットワークモデルの「意思決定プロセスの分解」を目的としています。しかし、現在のニューラルネットワークモデルはすべての意思決定プロセスをブラックボックスモデル内でカプセル化しているため、理解することはほぼ不可能です。

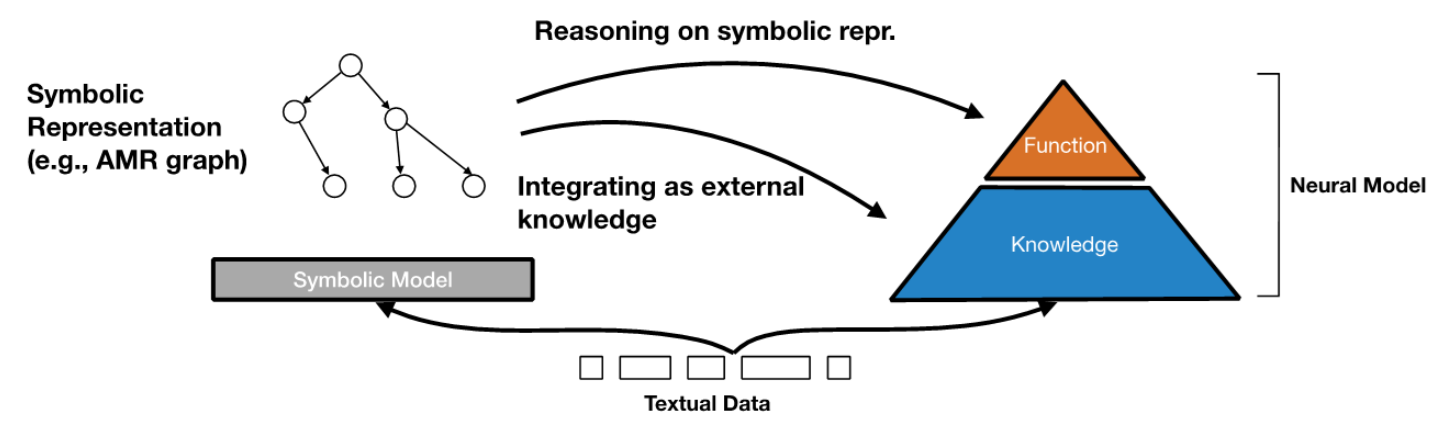

一方で、シンボリックシステムは明示的なルールと表現に基づいており、より優れた解釈可能性を示します。そこで、ニューラルサブシステムとシンボリックサブシステムを組み合わせた「ニューロシンボリックアプローチ」を提案しました。

このニューロシンボリックアプローチでは、複雑なパターンのタスクを処理して高次元の表現を捉えられるニューラルサブシステムと、意思決定において透明性があり解釈可能なフレームワークを提供するシンボリックサブシステムの、両方の利点を活用できます。本アプローチによりブラックボックスの性質を解明できれば、ニューラルネットワークモデルの意思決定プロセスはもちろん、全体の解釈可能性が高まると考えられます。

モデルの内部動作を理解することで、バイアスや誤った出力、信頼性の低い意思決定に関連する問題を特定・軽減する

モデルの内部動作を理解することで、バイアスや誤った出力、信頼性の低い意思決定に関連する問題を特定・軽減する自然言語生成タスクの観点から本手法を評価するため、ニューロシンボリックアプローチの研究指針に沿って n-gram 言語モデルや検索モデルなど、明確な推論ロジックを示す複数の重要なシンボリックシステムの統合を目指しました。そうしたシンボリックモデルの意思決定情報を意思決定プロセスに統合した研究成果を、EMNLP 2022 で発表しました。

本アプローチは、まだ強化の余地が存在します。今後も解釈可能性とパフォーマンスのバランスを考慮しながら、モデルの意思決定プロセスを分解する方法を提案していきます。

研究の初期段階では望んだ実験結果がほとんど得られなかったが、課題を分析し、新しいアプローチを構築して仮説の再検証を重ねることで、ここまで進めることができた

研究の初期段階では望んだ実験結果がほとんど得られなかったが、課題を分析し、新しいアプローチを構築して仮説の再検証を重ねることで、ここまで進めることができた特別研究員に採用され、多くの貴重な経験を得た

現在のAI は主に深層学習に基づいており、高い計算リソースを必要とします。私が優れた計算機器を購入し、仮説を検証して実験の進行を加速できたのは、特別研究員奨励費のおかげです。また、国際会議に参加し、本分野の最先端で活躍されている研究者の方々との広範な議論にも、加わることができるようになりました。

申請にはかなりの労力を要しますが、挑戦する学生の皆さんは、ぜひ前向きな姿勢で臨んでください。

採用されるか否かは関係なく、私たち一人ひとりは優れた研究を行う力を持っていると信じている

採用されるか否かは関係なく、私たち一人ひとりは優れた研究を行う力を持っていると信じている(取材・撮影:ライティング株式会社 酒井若菜)