モジュール強化学習

ATR連携講座

強化学習は個体が環境との相互作用により,

行動の目標に応じた報酬の総和を最大とするような行動則を

オンラインで獲得するための理論的枠組である.

しかし,環境のダイナミクスや報酬の設定に関する事前知識が全くない場合や,

またそれらが非定常に変化する場合,

多くの問題では学習に非現実的なほど時間がかかる.

そこで,環境の内部モデルを利用したり,

他者の行動を見まねるなどして学習を加速する事が重要な研究テーマとなる.

環境の内部モデルを用いるアプローチとして,

状態の変化を近似する状態予測モデル,

与えられる報酬を近似する報酬予測モデルを複数個用意し,

それらを局所的に配置しておき状況に合わせて切り替える事で制御を行う事が考えられる.

我々の日常においても身の回りにあるものは

多種多様なダイナミクスを持っており

また我々の行動の目標,

つまり報酬関数もその場その場で変化する.

よって,複数のダイナミクスと複数の報酬関数を近似するモデルを用いて

非定常な制御を行う方式は理にかなったものであると言える.

本研究では複数の状態予測モデルと複数の報酬予測モデルを用意し,

制御の各時刻において最適な組み合わせを選択することで

非線形・非定常なタスクに対応できるアルゴリズムの開発を行った.

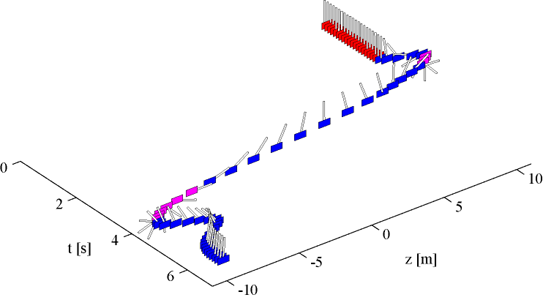

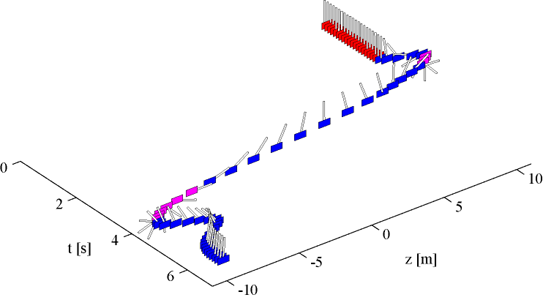

図1は報酬関数が非定常に変化するcart-poleタスク,

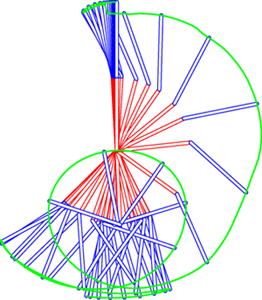

図2はアクロボットと呼ばれる非線形性の強いタスクへの適応例を示している.